Les dark patterns, le côté obscur des nudges

Nudge du côté « obscur », les dark patterns sont des techniques de conception d’interface qui visent à tromper ou manipuler un utilisateur pour qu’il effectue une action contre sa volonté ou son intérêt. De plus en plus répandues sur le web, les dark patterns sont mis en place pour maximiser les profits ou collecter le plus de données personnelles.

Au sein du design éthique et de l’expérience utilisateur, les dark patterns posent un problème, car ils contraignent l’utilisateur.

Mais au juste, quelle est l’origine des dark patterns, comment les reconnaître, quelles sont leurs conséquences ?

L’origine des dark patterns

« Motif », « patron », « schéma » sombre… il n’existe pas de réelle traduction en français pour traduire « dark patterns ». Tandis qu’un « pattern » est en génie logiciel une manière d’améliorer, de stabiliser ou de sécuriser un logiciel, les dark patterns sont eux des « manières sombres » d’influencer le comportement des utilisateurs.

Le terme « dark patterns » a été inventé par le Dr. Harry Brignull, spécialiste en expérience utilisateur, qui a créé en 2010 le site darkpatterns.org devenu deceptive.design en 2022, partageant des « astuces utilisées sur les sites web et applications pour inciter à faire des choses que nous ne voulons pas ».

En plus d’être une manne d’informations et d’exemples, ce site répertorie également des lois et des actualités autour des dark patterns.

Les types de dark patterns d’après Dr. Harry Bignull

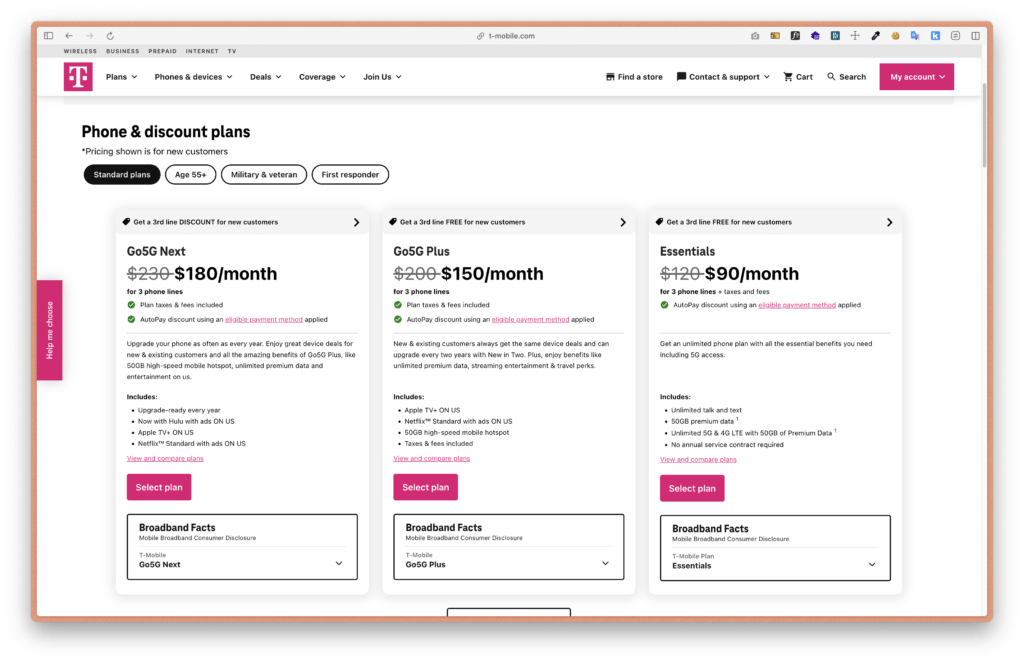

Prévention de la comparaison

L’utilisateur a du mal à comparer les fonctionnalités et prix d’un produit, car elles sont organisées de manière complexe ou sont compliquées à trouver.

Exemple : T-Mobile présente ses abonnements du plus au moins cher.

Confirmation de la honte

L’utilisateur est manipulé pour faire quelque chose qu’il n’aurait pas fait normalement

Exemple : Inciter à bénéficier d’une offre en utilisant un label de bouton de refus singulier

Publicités déguisées

L’utilisateur croit cliquer sur un élément d’interface ou du contenu natif alors qu’il s’agit d’une publicité

Exemple : Les publicités avec des faux boutons de téléchargement sur les sites de téléchargement de logiciel.

Fausse pénurie

L’utilisateur est poussé à effectuer une action (le plus souvent un achat) en raison d’une offre limitée ou de la popularité.

Exemple : Afficher un stock bas et un nombre de ventes haut dans un laps de temps très court induit une fausse popularité. Ci-dessous, Digitec met en avant des offres flashs avec un stock limité.

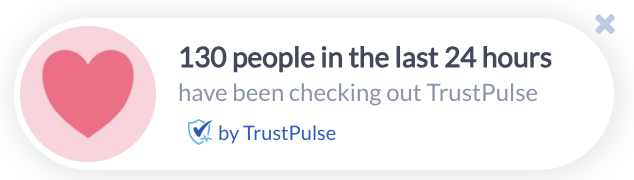

Fausse preuve sociale

L’utilisateur est induit en erreur en raison d’un grand nombre de témoignages, de faux témoignages…

Exemple : Plusieurs extensions comme Trustpulse montrent des notifications « en direct » sur l’activité du site (réservation, achat…)

Fausse urgence

L’utilisateur est poussé à effectuer une action, car il se voit présenter une fausse limite de temps

Exemple : Les newsletters avec un compteur indiquant la fin d’une promotion

Action forcée

L’utilisateur souhaite faire une action, mais le système lui demande d’en faire une autre indésirable en retour

Exemple : Obliger un client à créer un compte pour passer commande.

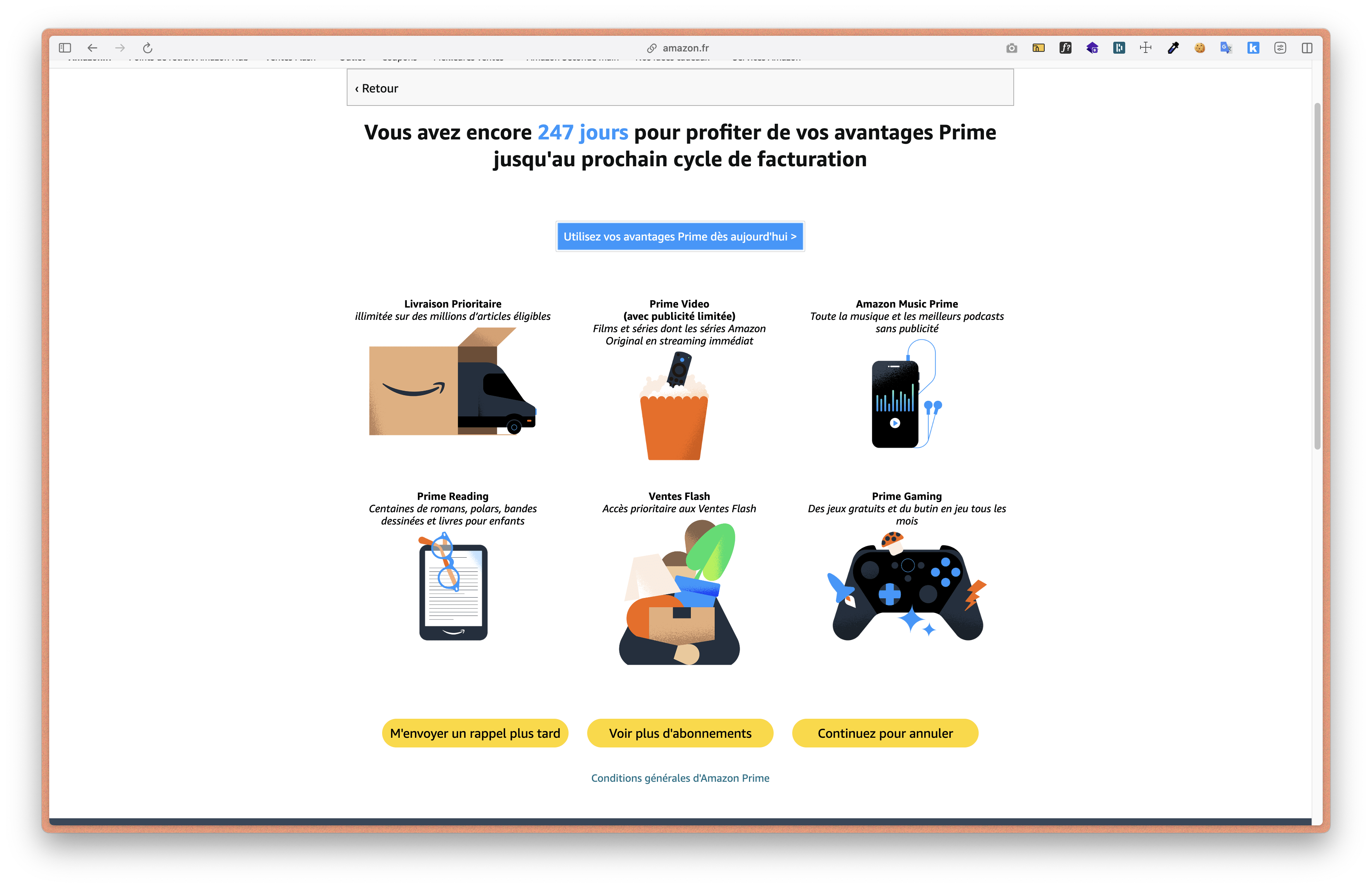

Difficile à annuler

Après avoir été très facilement inscrit, l’utilisateur voit sa désinscription compliquée, voire impossible.

Exemple : Résilier un abonnement Amazon Prime nécessite plusieurs actions et passe par plusieurs étapes de dissuasion.

Coûts cachés

L’utilisateur est attiré par un prix bas, mais se retrouve avec des frais inattendus après avoir investi des efforts

Exemple : Sur UberEats, les frais ne sont pas annoncés lors du passage de la commande, mais juste à la validation.

Abonnement caché

L’utilisateur est inscrit sans le savoir à un abonnement récurrent

Exemple : Sur Figma, quand utilisateur autorise un invité à partager, ce premier se fait facturer sans le savoir un abonnement.

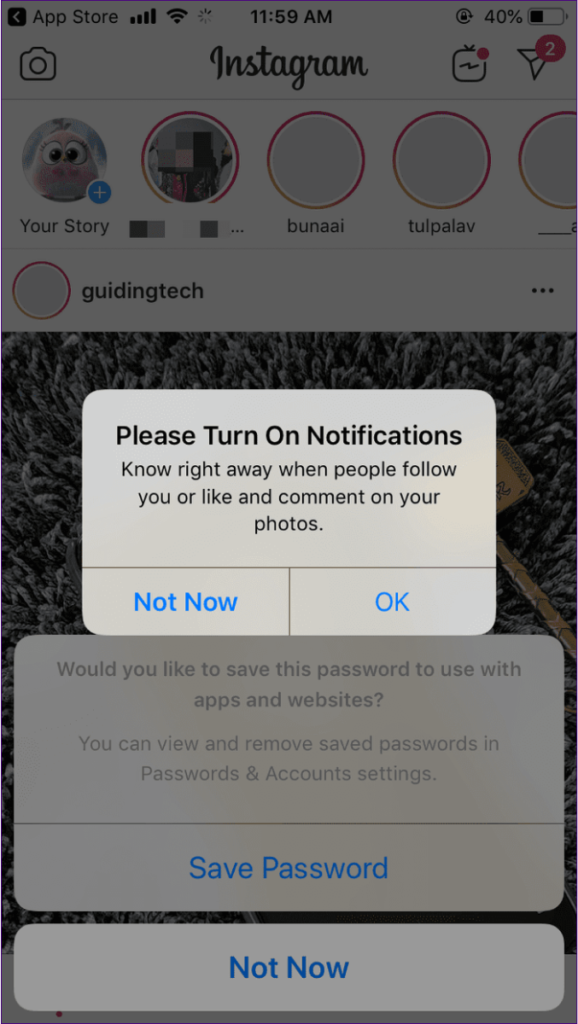

Harcèlement

L’utilisateur cherche à effectuer une action, mais est constamment interrompu

Exemple : Les réseaux sociaux incitant à activer les notifications à chaque ouverture de l’application (comme Instagram en 2018)

Obstruction

L’utilisateur est confronté à des obstacles pour effectuer son action

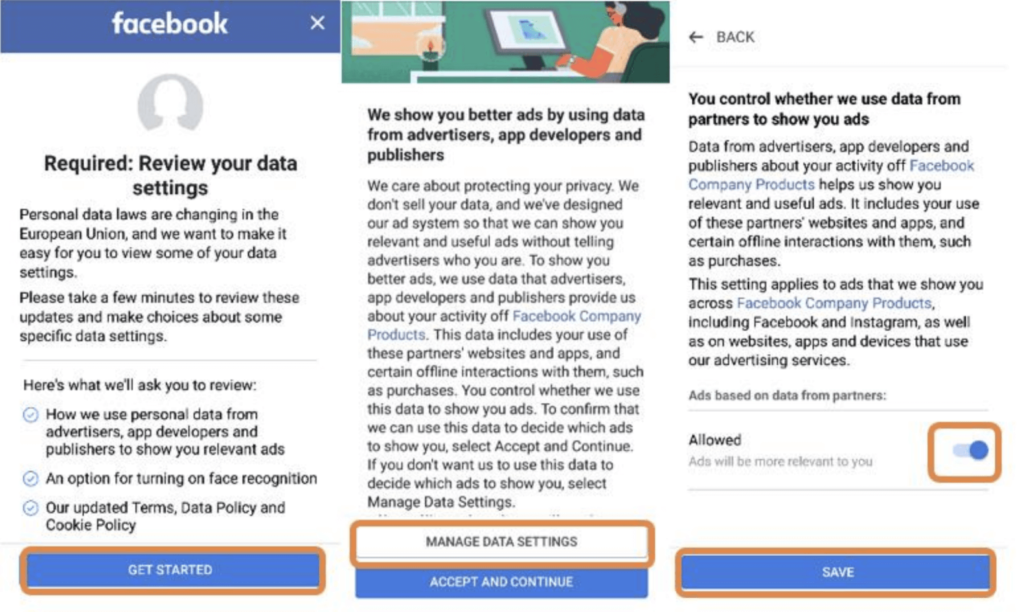

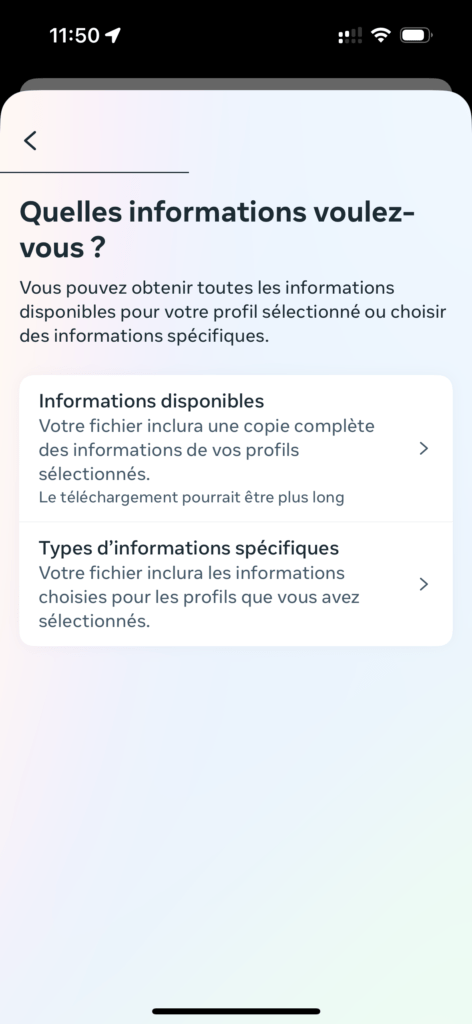

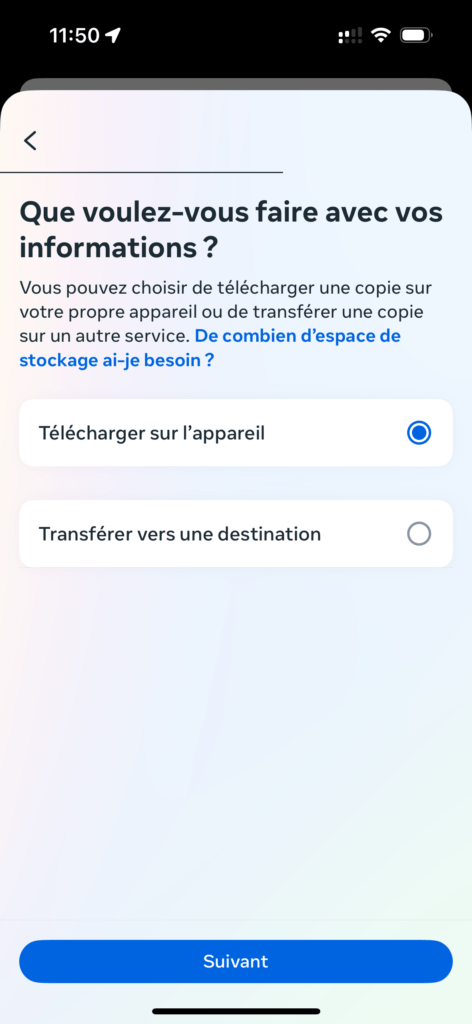

Exemple : Si utilisateur souhaite recevoir ses données personnelles de la part de Facebook, il est submergé d’informations et d’étapes dissuasives. (Bien que ce soit plus simple aujourd’hui qu’en 2018)

Présélection

Une option est sélectionnée par défaut pour influencer la prise de décision.

Exemple : Un ex-employé d’une entreprise cybercriminelle révèle dans une vidéo d’Underscore_ que certains services permettent de télécharger des logiciels populaires contenant des malwares dissimulés. Hors installation avancée, des extensions sont ajoutées sur l’ordinateur pour suivre tout ce qu’un utilisateur fait sur le web pour lui proposer des publicités toujours plus ciblées.

Faufilage

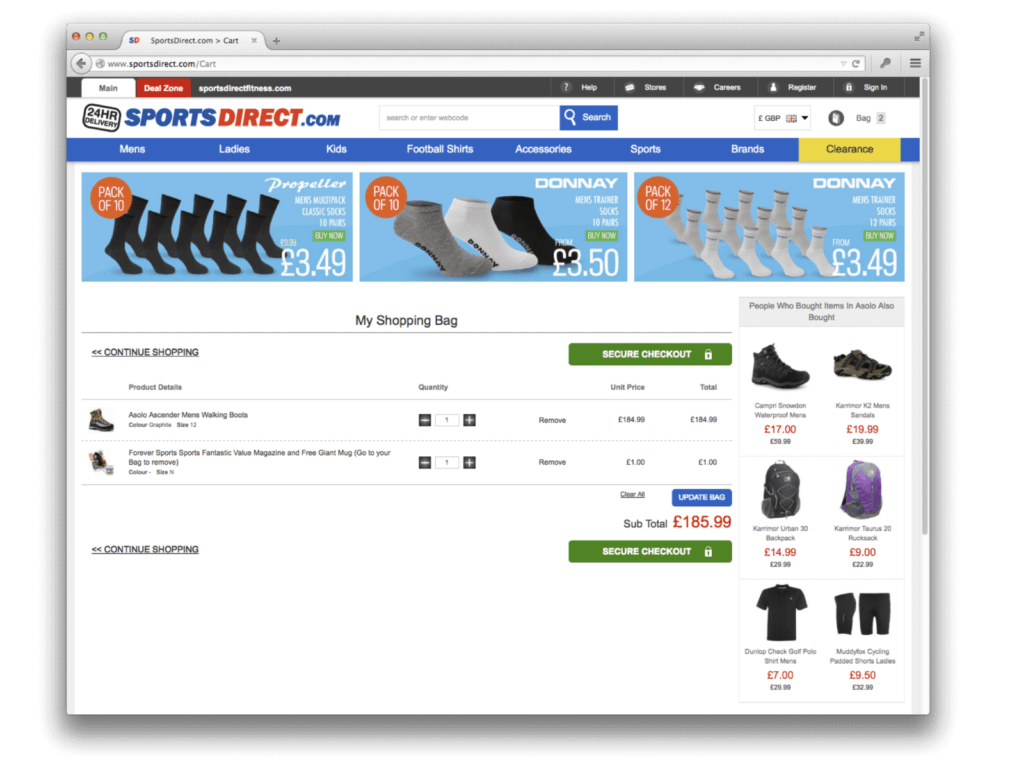

L’utilisateur est entraîné dans une transaction sous de faux prétextes en ayant qu’une partie des informations.

Exemple : En 2015, le site sportsdirect.com introduisait à chaque achat un abonnement à un magazine non désiré dans le panier des utilisateurs pour 1 £ de plus.

Formulation astucieuse

L’utilisateur est induit en erreur par le choix des mots.

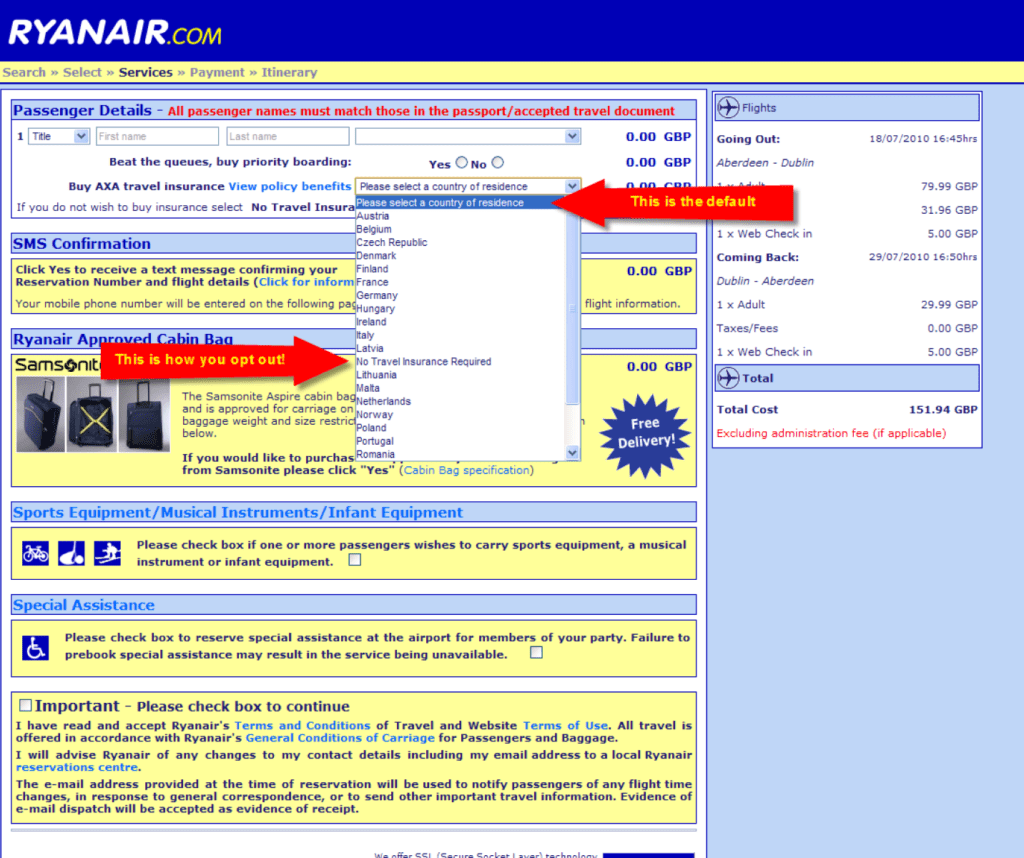

Exemple : Début des années 2010, Ryanair ajoutait insidieusement une assurance voyage en demandant aux voyageurs de sélectionner leur pays de résidence dans une liste déroulante. Pour ne pas choisir d’assurance voyage, les utilisateurs devaient le choisir dans la liste. La mention indiquant comment ne pas prendre cette assurance était inscrite en dessous et était masquée par la liste déroulante.

Interférence visuelle

L’utilisateur s’attend à voir des informations présentées de manières claires, mais celles-ci sont cachées ou déguisées

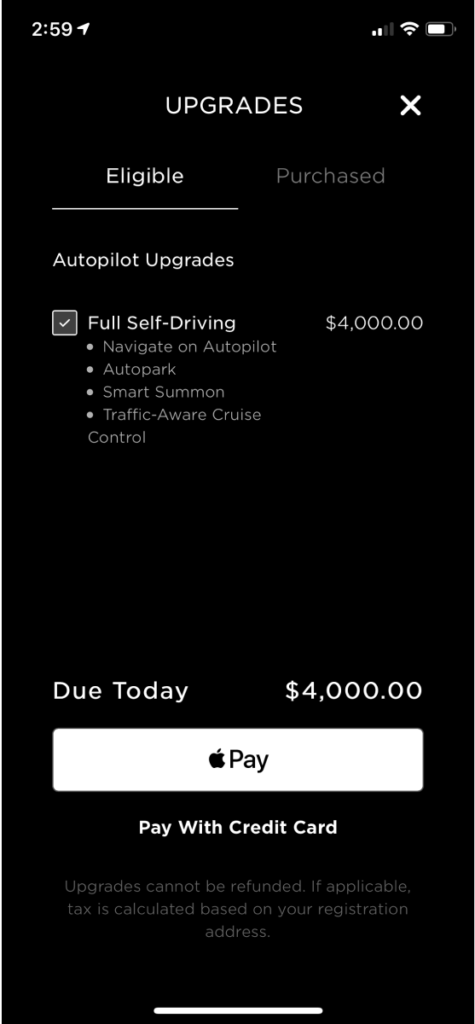

Exemple : En 2019, il était possible d’acheter une mise à jour (auto pilotage, parking automatique…) de sa Tesla depuis l’application mobile. Certains utilisateurs, ayant acheté cette option par erreur, ont porté réclamation, mais la mention concernant le remboursement impossible était peu visible sur la page.

Les conséquences des dark patterns

Les dark patterns sont des nudges insidieux qui tendent à pénaliser l’utilisateur face à une action qui n’est pas arrangeante pour une entreprise.

De nombreux utilisateurs font les frais chaque jour de ces dark patterns tandis que de nombreuses entreprises et services marketing inventent de nouvelles manières de détourner l’utilisateur de son action première pour arriver à leur fin.

Les conséquences des dark patterns peuvent être plus ou moins grave suivant le degré du dark patterns. Les utilisateurs peuvent alors perdre confiance ou se révéler plus méfiants s’ils observent le même schéma de nouveau.

L’exemple le plus connu est celui de Facebook qui a été vivement critiqué pour son utilisation de dark patterns. En 2018, l’entreprise Cambridge Analytica a été portée en justice suite à sa collecte de millions d’utilisateurs de Facebook, sans un quelconque consentement. Cette affaire a fait perdre à Facebook la confiance de ses utilisateurs et a conduit le réseau social à être la cible d’enquêtes gouvernementales. Facebook a alors dû modifier sa politique de confidentialité afin de respecter un peu plus ses utilisateurs.